Introdução aos princípios conexionistas

Por Rogério Perino de Oliveira Neves

Introdução

Próximo ao final do século XIX, Santiago Ramon y Cajal realizou

experimentos determinantes para a formação inicial do modelo conexionista,

concluindo que o cérebro era formado por células discretas, conectadas entre si

por ligações especiais, chamadas posteriormente de sinapses. Porém, a anatomia

do cérebro é estudada há séculos. Os antigos gregos já praticavam dissecação,

tendo realizado as primeiras observações e experimentos básicos no estudo do

sistema nervoso, dando início a vários dos ramos da ciência que estudam o

cérebro (neuroanatomia, neurofisiologia, psicofísica, psicologia, etc.).

Aqui

sintetizaremos brevemente alguns dos experimentos que foram significativos para

o ponto de vista conexionista, enfocando os mais recentes e algumas das

aplicações derivadas desse conhecimento.

Em

seguida, apresentamos uma breve introdução sobre o funcionamento dos neurônios,

células básicas que constituem o cérebro, suas várias formas e organizações em

redes.

Finalmente,

teremos uma síntese das tecnologias derivadas do estudo sistemático das redes

neurais, desde a criação de modelos de redes neurais artificiais para solução

de problemas específicos, até a tentativa de modelamento e simulação de um

sistema nervoso real, utilizando tecnologias digitais.

Toda

riqueza histórica do estudo da mente é retratada em detalhes em literaturas

específicas; aqui, retrataremos apenas eventos de maior notoriedade, deixando

outros que, embora não menos importantes, são menos necessários ao entendimento

introdutório da filosofia conexionista objetivado neste texto. O leitor que

desejar se aprofundar em algum dos assuntos cobertos poderá recorrer às

referências fornecidas na relação bibliográfica.

Por

muitos séculos persistiu a crença de que o cérebro abrigava um pequeno ser,

oculto na glândula pineal, onde Descartes acreditava ser “o sítio da alma”. Tal

ser era chamado de homúnculo e era responsável pelo controle e ações de todo o

corpo. O conhecimento adquirido ao longo dos séculos vem contribuindo para

descaracterização desse ser. Porém, muito ainda há para ser estudado e

explicado. A ciência nega a seus praticantes o direito de ignorar dados e

experimentos, mesmo que seus resultados, por vezes, entrem em conflito com

crenças advindas de bases sociais, culturais e religiosas. Devemos recorrer ao

passado, lembrando que muitas dessas crenças “dogmáticas” caíram por terra ao

longo dos séculos, com o avanço científico, o que ocasionou conflitos com

forças vigentes ao longo da história. Aqui trataremos apenas de fatos e dados

com embasamento científico, deixando discussões filosóficas e religiosas para

debates complementares.

N.Y.S.

Kiang ilustra o estudo do cérebro com uma observação singular:

“…

Neurofisiologia pode ser descrita como uma ciência rica em dados, mas pobre em

teoria”.

Experimentos significativos

Na

antiga Grécia há registro da prática da dissecação e das primeiras observações

registradas sobre o cérebro. Atribui-se a Hipócrates a observação: “… o

cérebro parece uma glândula, é branco e separado em pequenas massas, como as

glândulas são…”. Herófilo descreve os troncos nervosos como tubos que unem

as extremidades do corpo à medula espinhal e ao encéfalo. Posteriormente,

Galeno associa esta estrutura à transmissão da informação sensorial e motora.

Em

1644, Descartes forneceu uma descrição detalhada do arco reflexo, uma resposta

muscular a um estímulo doloroso. Em 1650, experimentos foram realizados pelo

holandês Swammerdam que, removendo um músculo da perna de uma rã, verificou que

este se contraia sempre que era perturbado ou irritado.

No

início do século XIX, Müller, considerado por muitos o “pai da fisiologia”,

escreveu um prognóstico negativista (típico dos cientistas daquela época)

dizendo: “…provavelmente nunca conseguiremos medir a velocidade da ação

nervosa, uma vez que não podemos comparar sua propagação em um espaço interno

como fazemos com a luz.”. Acreditava-se, até então, que os impulsos

nervosos propagavam-se com a velocidade da luz. Pouco durou tal pensamento. Em

1850, Hermman Ludwig Ferdinand von Helmholtz, pupilo de Müller e um dos mais

importantes cientistas do século XIX, mede a velocidade de propagação dos

estímulos nervosos, com um aparato inteiramente mecânico, obtendo o valor de

61m/s para os nervos sensoriais do homem, valor inteiramente consistente com os

obtidos com técnicas atuais. Mais tarde, Dubois-Reimond descobre a natureza

elétrica da ação nervosa e realiza medidas precisas da propagação dos estímulos

utilizando galvanômetros.

Ainda

no século XIX, o inglês Bell e o francês Megendie realizaram experimentos em

diversas partes do mecanismo sensorial, sintetizando-os em uma lei que, pela

primeira vez, estabelece uma taxonomia das funções realizadas no sistema

nervoso.

A

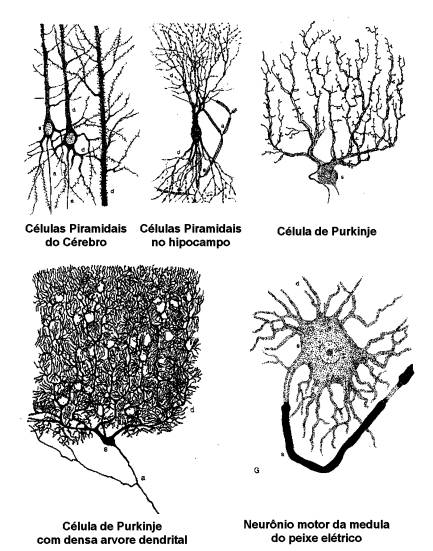

neuroanatomia celular, iniciada em 1837 por Purkyne, teve seu grande avanço com

trabalhos realizados pelo cientista espanhol Ramon y Cajal, que descrevem com

grande detalhe a taxonomia de vários neurônios do sistema nervoso e suas

respectivas árvores dendritais, assim como aglomerados dessas células, formando

as redes de processamento de informação no sistema nervoso.

Em

1906, o cientista inglês Sherrington publica “The Integrative Action of the

Nervous System”, que descreve experimentos feitos em animais, associando

diversas deficiências causadas por remoção de partes do córtex e medula

espinhal, criando os termos “neurônio” e “sinapse” para descrever a célula

nervosa e seus botões de contato. Em 1909, Brodman mapeia o córtex humano em 50

áreas por critérios cito-estruturais.

O

avanço mais significativo em eletroneurofisiologia se deu graças a Hudgkin e

Huxley, que modelaram em 1960 os processos biofísicos envolvidos na geração do

potencial de ação do neurônio, trabalho que lhes valeu o prêmio Nobel de

Fisiologia em 1963.

Desenvolveu-se,

ainda, a neurofisiologia funcional, onde certas funções primitivas do sistema

nervoso são associadas às áreas corticais específicas, mediante estudo

sistemático de pacientes lobotomizados, que tiveram de alguma maneira parte do

córtex avariado ou removido. Neste aspecto, ressalta-se o trabalho do

neurofisiologista Roger Sperry, que recebeu em 1981 o prêmio Nobel de

Fisiologia pelo seu trabalho.

Atualmente,

tecnologias como a microscopia eletrônica e técnicas modernas de mapeamento de

funções cerebrais, como tomografia computadorizada (CAT-Scan, PET-Scan) e

ressonância magnética (NMR), permitem a visualização do sistema nervoso em

pleno funcionamento, levando a um avanço rápido e eficiente das ciências que estudam

o sistema nervoso, deixando pouco espaço para o “homúnculo”.

O neurônio biológico

O

neurônio é constituído por um corpo somático, ou soma de onde derivam inúmeros

dendritos, formando uma árvore dendrital, e um único axônio, que pode

apresentar algumas ramificações. Sua taxonomia foi inicialmente estudada por

Ramón y Cajal, que descreve em detalhes vários tipos de neurônios encontrados

em sistemas nervosos. Sua extensão pode variar desde algumas centenas de

mícrons até alguns metros.

As

conexões entre os neurônios se dão por meios de sinapses, que podem ser

excitatórias ou inibitórias, dependendo do mecanismo e neurotransmissores

envolvidos nessa sinapse. O funcionamento do mecanismo sináptico é pouco

conhecido, porém, vem sendo estudado exaustivamente em vários ramos da ciência

(medicina, biofísica, biologia, etc.). Os dendritos se conectam aos axônios de

outras células, servindo como receptores de sinal, enquanto o axônio tem a

função de transmitir um pulso, dada a condição de disparo, conhecida como

“potencial de ação”. Na transmissão do impulso elétrico, a sinapse efetua a

troca de ions entre o citoplasma do axônio do neurônio transmissor e o dendrito

do neurônio receptor.

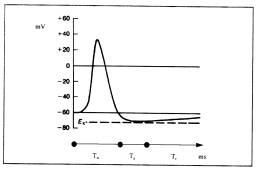

A

condição de disparo se dá quando o potencial da célula em relação ao meio

salino que a cerca atinge um determinado patamar. Esse patamar é conhecido como

limiar de disparo. Quando uma célula encontra-se com potencial positivo ela é

dita “polarizada”; é então acionado um mecanismo somático conhecido como

“bombas de íons” visando a diminuição da diferença de potencial na membrana até

o nível normal. Uma vez atingido o limiar de disparo, a célula é dita

hiperpolarizada, é disparado um único pulso no axônio, levando o potencial da

célula ao valor de despolarização absoluta, onde permanece por um período de

refração absoluta (Ta), onde a célula é incapaz de produzir outro potencial de

ação, não importando a intensidade da despolarização. Isto limita a freqüência

de operação do cérebro a 1/Ta. Posteriormente, há um período de refração

relativa (Tr), onde o potencial retorna assintoticamente ao valor normal.

Hudgkin

e Huxley foram os primeiros a estudar o potencial de ação, realizando

experimentos onde, além de obter valores precisos de tensão natural e de

disparo, ainda produziram reações em neurônios “in vitro”, aplicando uma tensão

nos dendritos, obtendo disparos induzidos de células removidas do sistema

nervoso.

O

potencial de ação na membrana do axônio de um neurônio típico.

Redes neurais naturais e artificiais

Uma

vez estabelecida a fisionomia e funcionamento do neurônio, podemos simplificar

sua representação considerando um sistema de n entradas com pesos distintos

aplicados, que, sendo x a soma ponderada,

dada uma função de ativação g(x), gera uma única saída como função da

entrada.

Modelo

simplificado do neurônio

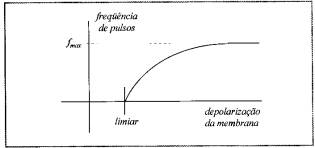

Uma

vez determinada a função g(x), o comportamento desse neurônio é puramente

determinístico. A função g(x) do neurônio é conhecida e retratada na figura

abaixo.

Resposta

neural: freqüência da despolarização dada a intensidade do estímulo

A

função característica do neurônio então se dá pela integração temporal-espacial

dos estímulos recebidos:

É aí

que o leitor atento pergunta: Então o cérebro nada mais é que uma máquina

composta de inúmeras unidades analógicas funcionais determinísticas? Por que,

então, não podemos determinar as ações de cada indivíduo? Ninguém poderia

responder a primeira pergunta sem confrontar filosofias e crenças

pré-estabelecidas. Já o comportamento não determinístico da mente, dada a

simplicidade de sua estrutura, remete à teoria de autômatas celulares, que

afirma que uma população de autômatas que implementam funções determinísticas

simples, quando combinados em estruturas complexas, podem produzir resultados

complexos e não determinísticos.

Para

efeitos de simplificação de modelos, a função resposta pode ser aproximada por

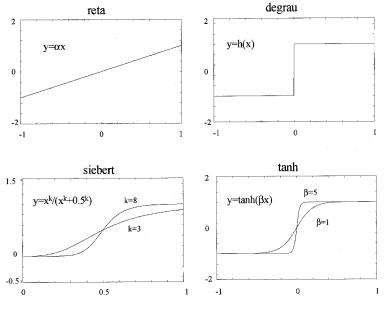

várias funções analíticas:

Funções

de ativação comumente empregadas em modelos de neurônios

Baseado

nestas aproximações e nos trabalhos realizados por Alan Turing e John von

Newman (que afirmavam que a álgebra booleana era a natureza essencial da

inteligência), Warren McCulloch, médico, filósofo, matemático e poeta,

juntamente com o estatístico Walter Pitts, publicaram um artigo no Bulletin of

Mathematical Biophysics com o título: “A Logical Calculus of the Ideas Immanent

in Nervous Activity”, que se tornou referência absoluta para a teoria das redes

neurais artificiais, sendo este tambem o primeiro paper escrito nessa área.

O

modelo de neurônio booleano era ingenuamente simples, exageradamente simples,

considerando toda a informação já disponível naquela época sobre o

comportamento elétrico da célula nervosa. Porém, baseado neste modelo,

McCulloch implementou uma série de funções, onde, eram atribuídas as entradas

um ganho arbitrário, gerando uma soma devidamente ponderada (ou subtração no

caso de sinapses inibitórias), resultando em uma única saída: pulso, no caso da

soma exceder um dado limiar, ou não-pulso, caso contrário.

Algumas

funções booleanas implementadas por McCulloch

O

neurônio booleano nada mais é que um caso particular de um descriminador

linear, de entradas binárias que pode ser representado pela função:

![]()

A

função signal retorna –1 para parâmetros negativos e +1 para positivos,

e o teta representa o limiar de ativação.

Modelo

do neurônio como discriminador linear

Em

1950, Rosenblatt, na Universidade de Cornell, fez a primeira implementação

genuína das idéias de McCulloch, utilizando múltiplos neurônios do tipo

discriminadores lineares em rede de múltiplas camadas, experimento a qual deu o

nome de “perceptron”. O perceptron possui uma camada de entrada,

uma de saída, e uma ou mais camadas internas a entrada e saída, que são geralmente

referias como camadas ocultas.

Modelo

do perceptron de Rosenblatt

A

primeira vista, o discriminador linear de Rosemblatt não passa de uma função

linear de n dimensões onde os pesos de cada conexão dados

arbitrariamente, e de fato, neste estado é de pouco uso. Porem, dado um

conjunto de exemplos com xi entradas e yi

saídas desejadas, este mecanismo se torna um poderoso reconhecedor de padrões,

que , como os similares biológicos, é capaz de aprender uma determinada função.

Utilizando-se de um processo de treinamento com o uso dos exemplos, é possível

alterar os pesos de cada conexão de forma a obter (na maioria dos casos) um

determinado conjunto de saída, dado um conjunto de entrada.

Baseado nesta teoria, Rosenblatt construiu um perceptron, o qual

batizou de mark1, onde um vetor de entrada de 400 dimensões advindo de uma

matriz de fotocélulas organizadas em matriz 20 x 20 pixels era colocado na

entrada, podendo reconhecer caracteres de um alfabeto, uma vez devidamente

treinado para este fim.

Padrões

de um alfabeto de dígitos 0-9, corretamente classificados por uma rede neural

O

treinamento visa a convergência da função para um limite que separe

corretamente grupos em um conjunto de n dimensões. Um modelo de treinamento

proposto por D. Hebb consiste nos seguintes passos:

![]()

![]()

O

parâmetro k é referido como taxa de aprendizado, geralmente é igualado a um,

porém, pode-se atingir uma convergência mais rapidamente modificando-o conforme

o conjunto de treinamento utilizado.

A

utilização do modelo acima é eficiente na maioria dos casos separáveis, e

mostra-se que a função converge para o conjunto desejado em poucas interações.

No caso de conjuntos não totalmente separáveis, ou que contenham

cross-sections, quanto maior o número de exemplos aplicados, menor será o erro

obtido nas classificações. Erros aceitáveis nestes casos situam-se entre 1% e

20% dependendo da natureza da intersecção dos conjuntos. Se os conjuntos forem

completamente superpostos, a rede jamais converge, e fica oscilando entre

valores intermediários do cruzamento.

O

neurônio de Rummelhart, Hinton e Williams (RHW) foi o primeiro a empregar o

algorítimo de backpropagation, que resolvia algumas limitações fundamentais no

treinamento de redes complexas.

Neurônio

de Rummelhart, Hinton e Williams (RHW).

A retropropagação de erro (error

backpropagation) é um modelo de treinamento mais robusto e com álgebra mais

elaborada, atualmente o mais utilizado em redes neurais de múltiplas camadas,

uma vez que se demonstrou muito eficiente na maioria das aplicações

convencionais. A álgebra deste método é encontrada em Kovács (ver referência) e

outras literaturas específicas.

Redes

neurais atuais encontradas em aplicações comerciais e projetos aplicam as mais

diversas técnicas para minimizar os erros de classificação, aperfeiçoar o

conhecimento com erros detectados em tempo de execução (auto-adaptação), criar

discriminadores não lineares (redes neurais com base radial e multifuncionais)

e funções de ativação das mais esdrúxulas, de forma a obter um resultado

análogo, ou ao menos aproximado, ao deferido por um ser humano ordinário.

Alguns

exemplos de tecnologias comerciais que utilizam sistemas com redes neurais

artificiais são:

Reconhecedores

de escrita: Palm, handhelds, Pocket-PCs, etc.

Reconhecedores

de voz: Dragon, IBM-Via-Voice, Vocall.

Identificadores

de padrões visuais: Sistemas especialistas, satélites, radares, etc.

Sistemas de sensoriamento industrial: Para falhas mecânicas em linhas de

produção e montagem.

Sistemas

classificadores diversos.

Projetos

em inteligência artificial, vida artificial, ciências cognitivas, entre outros.

Finalizando

esta breve introdução aos princípios da teoria conexionista, seguem algumas

frases célebres conectadas de certa forma à ciência cognitiva num contexto mais

abrangente. Para refletir e expandir suas possibilidades neuro-sinápticas.

“Quando

eu disse ao caroço de laranja, que dentro dele dormia um laranjal inteirinho,

ele me olhou estupidamente incrédulo".

-

Hermógenes, filósofo e cientista grego.

“...

Mentes criativas são reconhecidas por resistir a todo tipo de mau treinamento”.

-

Anna Freud, psicanalista.

"Imaginação

é mais importante que inteligência".

-

Albert Einstein – Físico alemão.

"O

gênio fala muitas vezes mal e não sabe gramática. Mas transporta montanhas,

constrói cidades, estabelece estradas de ferro e telégrafos. Muitos homens

cultos falam e escrevem muito bem, mas são incapazes de construir e

criar".

-

Prentice Mulford.

"Aprender

com a experiência dos outros é menos penoso do que aprender com a

própria".

-

José Saramago - Escritor português.

"A

fábrica do futuro terá apenas dois operários: Um homem e um cachorro. A função

do homem será alimentar o cachorro, e a do cachorro será não deixar o homem tocar

nas máquinas".

- Walter Block - Autor de Defending the Undefendable

“...

Se você obedece a todas as regras, perde toda a diversão...”.

- Katherine Hepburn, atriz.

Bibliografia

Geoffrey M. Cooper – The Cell, ASM Press

Kovács,

Z. L. – O cérebro e sua mente, Edição

acadêmica

Kovács,

Z. L. – Redes neurais artificiais,

Edição acadêmica

Imagens

cedidas por Zsolt Kovács.

Rogério

Perinio de Oliveira Neves

http://www.lsi.usp.br/~rponeves